Experience Unprecedented Adult Entertainment with Innovative NSFW AI Tools & Technology.

Explore, Enhance, Enjoy.

Featured NSFW AI Tools

Explore the forefront of adult-oriented AI technology with our curated list of top NSFW AI tools. These platforms offer innovative solutions for creating, enhancing, and enjoying adult content with the power of artificial intelligence. Designed with privacy and ethical considerations, each tool provides a unique way to explore adult themes safely and responsibly.

-

Porn Works AI

Regular price $2.39Regular priceUnit price / per -

GirlfriendGPT

Regular price $12.00Regular priceUnit price / per -

Seduced AI

Regular price $0.83Regular priceUnit price / per -

BestFaceSwap

Regular price $4.16Regular priceUnit price / per -

Promptchan AI

Regular price $4.99Regular priceUnit price / per -

CreatePorn.com

Regular price $1.00Regular priceUnit price / per -

SexSelector

Regular price $1.00Regular priceUnit price / per

Top Collections

View all-

AI Girlfriend

AI Girlfriends are the next revolutionary step in virtual companions. They combine...

-

AI NSFW Art & Image Generators

With AI NSFW Art & Image Generators, even the most inexperienced and...

-

AI NSFW Characters

AI NSFW Characters have changed the way we interact with virtual companions....

-

Adult Games

AI-powered porn games are all the rage in adult entertainment, and we...

-

AI NSFW Entertainment & Fun

AI-powered NSFW entertainment and fun tools are set to revolutionize the way...

-

NSFW AI Face Swap

The best NSFW face swap tools on the market are carefully designed...

-

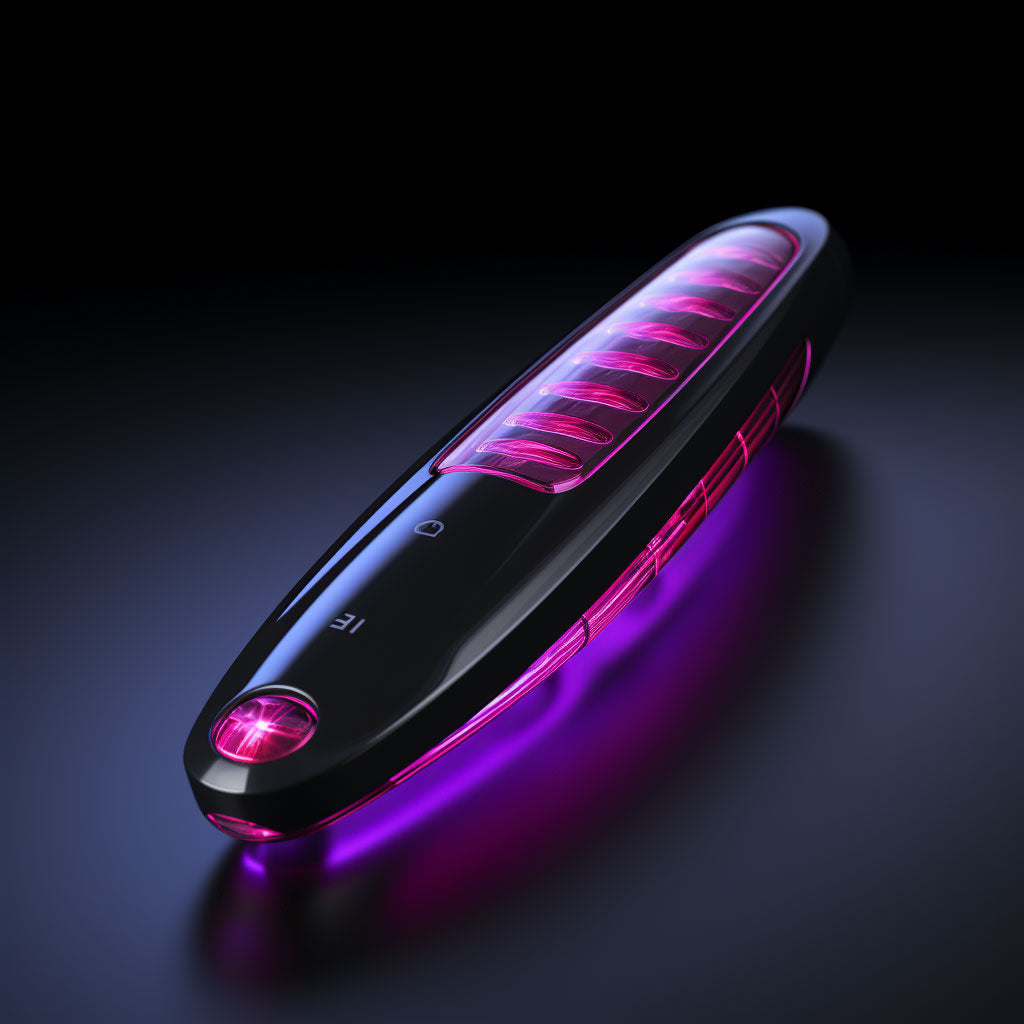

AI-Powered Interactive Adult Toys

AI-powered interactive adult toys powered by the most advanced artificial intelligence promise...

-

AI Hentai Generators

AI hentai generators are making strides in the digital artwork world. Relying...

-

AI Undress

As you delve into the world of AI undress tools, you get...

Latest From Our Blog

View all-

Falling for An Algorithm: Why Artificial Intima...

In this blog post, we explore the world of AI relationships and intimacy. Why does talking to an AI chatbot feel so real, and what can we do to prevent...

Falling for An Algorithm: Why Artificial Intima...

In this blog post, we explore the world of AI relationships and intimacy. Why does talking to an AI chatbot feel so real, and what can we do to prevent...

-

VEO 3 Has Hit The Internet - The True Revolutio...

VEO 3 is out of the doors, and it marks the next step in AI film evolution. With the ability to seamlessly generate sounds in films, the possibilities are endless!

VEO 3 Has Hit The Internet - The True Revolutio...

VEO 3 is out of the doors, and it marks the next step in AI film evolution. With the ability to seamlessly generate sounds in films, the possibilities are endless!

-

Playing With The Ghibli AI Converter - How We’v...

The Ghiblification of memes has been trending online recently, which has made us raise the question of its potential application in the realms of the NSFW side of AI.

Playing With The Ghibli AI Converter - How We’v...

The Ghiblification of memes has been trending online recently, which has made us raise the question of its potential application in the realms of the NSFW side of AI.

-

Pitfalls Of Training NSFW AI - A Far Insidious ...

What can we expect going forward for the future of NSFW AI, and are the current trends healthy for the wider AI use? We will discuss a few key factors.

Pitfalls Of Training NSFW AI - A Far Insidious ...

What can we expect going forward for the future of NSFW AI, and are the current trends healthy for the wider AI use? We will discuss a few key factors.

-

Introducing: NSFW Video Generation for Female C...

AI-generated videos are something that spiked up in the porn industry just recently. We’ll look to see if they are any good or if they are a waste of your...

Introducing: NSFW Video Generation for Female C...

AI-generated videos are something that spiked up in the porn industry just recently. We’ll look to see if they are any good or if they are a waste of your...

-

Plus One In The Team For A Threesome - Sex Doll...

Our blog will discuss the many ways in which you can use a sex doll with your partner as a group's third, the benefits, as well as potential nightly plays.

Plus One In The Team For A Threesome - Sex Doll...

Our blog will discuss the many ways in which you can use a sex doll with your partner as a group's third, the benefits, as well as potential nightly plays.

Unveiling the Hype: What's the Big Deal with AI NSFW Tools in Adult Entertainment?"

Dive into the heart of innovation as we explore the burgeoning fusion of artificial intelligence (AI) and the adult entertainment industry AKA NSFW AI Tools. This intriguing combination is reshaping the landscape, offering unprecedented experiences and stirring significant debate. Before we delve into the specifics, let's uncover why this integration is becoming the talk of the tech world and what it signifies for the future of digital entertainment.

Bringing Fantasies to Life: The AI Revolution in Adult Entertainment

Artificial Intelligence (AI) transforms the adult entertainment industry in ways once deemed the realm of fantasy. From creating deeply personalized experiences that cater to individual desires to enabling interactive content that responds and adapts to user inputs, AI is making the once-impossible possible. This technological leap forward allows for the exploration of fantasies in safe, controlled environments, offering a new level of immersion and personalization. As we delve into the benefits and use cases, we uncover how AI is not just enhancing adult entertainment but also revolutionizing the way fantasies are experienced and enjoyed, marking a new era of digital intimacy and interaction.

Enhancing Realism: AI Elevates the Authenticity in Adult Entertainment

In adult entertainment, artificial intelligence (AI) is breaking new ground by enhancing the realism of digital experiences. Through sophisticated algorithms and machine learning, AI can generate highly detailed, realistic content that blurs the lines between the virtual and the real. From lifelike avatars to environments that react in real-time to user interactions, AI is setting a new standard for authenticity. This leap in technological innovation not only improves the visual and interactive quality of content but also deepens users' emotional and sensory engagement. Explore how AI's drive for realism transforms adult entertainment, offering unprecedented immersion and connection.

Limitless Exploration: Navigating Infinite Possibilities with AI in Adult Entertainment

The fusion of artificial intelligence (AI) with adult entertainment unlocks endless avenues for exploration, catering to the vast spectrum of human desire and curiosity. AI's adaptive learning and generative capabilities enable the creation of diverse scenarios, personalized experiences, and innovative content that was once beyond imagination. This technological marvel allows users to venture into uncharted territories of their interests and fantasies, offering a boundless playground for exploration. By constantly evolving and expanding the boundaries of what's possible, AI in adult entertainment is not just enhancing user experiences—it's revolutionizing the way we explore and engage with digital fantasies, ensuring that the journey of discovery is never-ending.

Start Here: A Beginner's Guide to Safe and Ethical Consumption

Dive into the world of AI-enhanced adult entertainment with our essential guide. Discover key insights on legal issues, ethical considerations, and privacy tips to enjoy this evolving landscape responsibly and safely. Perfect for newcomers seeking a mindful approach to explore NSFW AI Tools.

Subscribe to Our Newsletter

Get the Latest & Hottest NSFW AI Tools, Exceptional Adult Entertainment Sites, Discounts & Coupons Directly in Your Inbox.